Wichtiger Fortschritt dank Google: Quantencomputer liegt erstmals unter der Fehlerschwelle

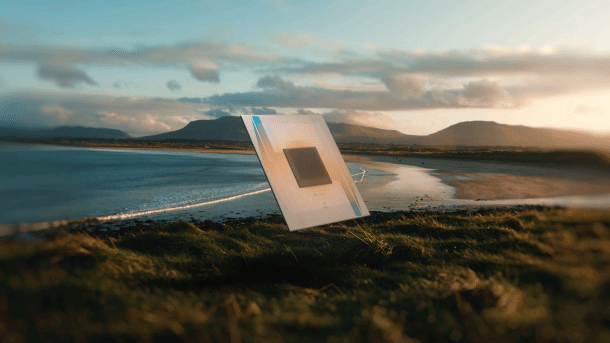

Forscher:innen von Google gelang es erstmals, die Fehlerrate eines Quantencomputers unter einen kritischen Schwellenwert zu senken. Dabei konnte die Fehlerrate trotz Verdoppelung der Qubitzahl halbiert werden. Damit erfüllt das Google-Projekt eine wichtige Voraussetzung für die Skalierung künftiger Quantencomputer. Im Rahmen des Projekts kam ein Quantenchip namens „Willow“ zum Einsatz, auf dem mehrere Daten- und Kontroll-Quantenbits zu logischen Qubits kombiniert werden. Außerdem wurden verbesserte Auslese-Techniken verwendet. Für die Entwicklung großskaliger Quantenrechner müssen aber weitere Verbesserungen vorgenommen werden.

Fehlerrate sinkt unter kritischen Schwellenwert

Quantencomputer gelten als nächster großer Schritt in der Informationstechnologie. Allerdings sind die dabei verwendeten Quantenbits sehr störanfällig, weshalb es trotz aufwändiger Fehlerkorrekturen in der Regel zu hohen Fehlerraten kommt. Diese Fehleranfälligkeit steigt mit wachsender Zahl der Qubits, weshalb Quantencomputer derzeit noch nicht auf die nötige Leistung skalierbar sind.

Sogenannte logische Qubits könnten eine Lösung für dieses Problem sein. Dabei handelt es sich um sogenannte Oberflächencodes, in denen mehrere benachbarte Daten- und Mess-Qubits zu einer Einheit kombiniert werden. Diese logische Qubits verfügen über eine spezifische geometrische Struktur, den Oberflächencode. Diese Struktur erlaubt es, die Fehler einzelner Qubits zu erkennen und auszugleichen. Diese neue Form von Fehlerkorrektur wurde 2021 von Google Quantum AI vorgestellt.

Dieses Team von Google Quantum AI machte nun einen weiteren Fortschritt: Erstmals gelang es, die Fehlerrate des Quantencomputers unter einen kritischen Schwellenwert zu senken. Diese Schwelle besagt, dass die Fehlerkorrektur exponentiell mit der Zahl der physikalischen Qubits pro logischem Qubit steigen muss, damit die auf logische Qubits basierenden Quantencomputer skaliert werden können.

Quantenchip „Willow“ erreicht historische Leistung

Hartmut Neven und seinem Team von Google Quantum AI gelang es nun, diesen Meilenstein zu erreichen. Dabei verwendeten die Forscher:innen einen neuen Quantenchip namens „Willow“. Dieser verfügt über Quantenprozessoren mit 72 und 105 supraleitenden Quantenpunkten als Qubits. Diese Qubits wurden zu logischen Qubits mit 17,49 oder 101 physikalischen Qubits zusammengefasst. Für ihre Tests ließen die Forscher:innen den Chip dann etwa eine Million Rechenzyklen lang laufen. Dabei ermittelten sie die jeweilige Fehlerrate. Dank neuer Auslese-Technik konnten die Daten nahezu in Echtzeit ausgelesen werden.

Dabei ergab sich, dass die Fehlerrate mit zunehmender Größe der logischen Qubits sinkt. „Jedesmal, wenn sich die Distanzen des Oberflächencodes um zwei erhöhen, reduziert sich der logische Fehler pro Zyklus um mehr als die Hälfte. Diese historische Errungenschaft wird in unserem Fachgebiet als ‚unter der Schwelle‘ bezeichnet – es verringert die Fehler, während man die Zahl der Qubits erhöht„, so die Forscher:innen.

Fehlerrate sinkt, Lebensdauer der Qubits steigt

Im Falle des 72-Qubit-Prozessors sank die Fehlerrate bis unter ein Millionstel. Für den 101-Qubit-Prozessor mit den größten logischen Qubits lag die Fehlerrate bei einem Tausendstel. Zudem können die Fehler und Fehlerraten dank des verbesserten digitalen Coprozessors quasi in Echtzeit ausgelesen werden. „Das ist wichtig, weil einige logische Operationen nicht-deterministisch sind – sie hängen von logischen Resultatmessungen ab, die unmittelbar interpretiert werden müssen“ erläutern die Forscher:innen.

Außerdem konnte sich die Lebensdauer der logischen Qubits auf 291 Mikrosekunden verdoppelt werden. Das liegt deutlich über dem, was von einzelnen Qubits erreicht werden kann. Somit verlängert sich dann auch die Zeit, in der Rechenoperationen durchgeführt werden können. Der Google-Quantenchip konnte den sogenannten Random Circuit Benchmark (RCS), eine Testaufgabe, in weniger als 5 Minuten erledigen. Der leistungsstärkste Supercomputer würde dafür 1025 Jahre benötigen.

Weitere Verbesserungen sind nötig

Die Forscher:innen gehen davon aus, mit ihrer Technologie wichtige Voraussetzungen für die Weiterentwicklung von Supercomputern erfüllt zu haben. „Unsere Resultate demonstrieren Systeme, die bei Skalierung die Anforderungen von großskaligen, fehlertoleranten Quantenalgorithmen erfüllen könnten„, schreibt das Team. Die Tatsache, dass die Experimente auch über mehrere Stunden mit bis zu einer Million Zyklen durchgeführt werden konnten, ohne dass es zu einem starken Leistungsabfall kam, sei eine weitere Voraussetzung, so die Forscher:innen weiter.

Bis die Technologie zu einem großen, tatsächlich einsetzbaren Quantencomputer skaliert werden kann, müssen jedoch noch einige Dinge verbessert werden. „Zwischen den aktuellen Fehlerraten und den Anforderungen für das praktische Quantencomputing liegen noch immer einige Größenordnungen„, schreibt das Team. Beim derzeitigen Stand der Fehlerkorrektur müssten logische Qubits mindestens 1.457 physikalische Qubits umfassen, um ausreichend niedrige Fehlerquoten auch für größere Quantencomputer zu erreichen.